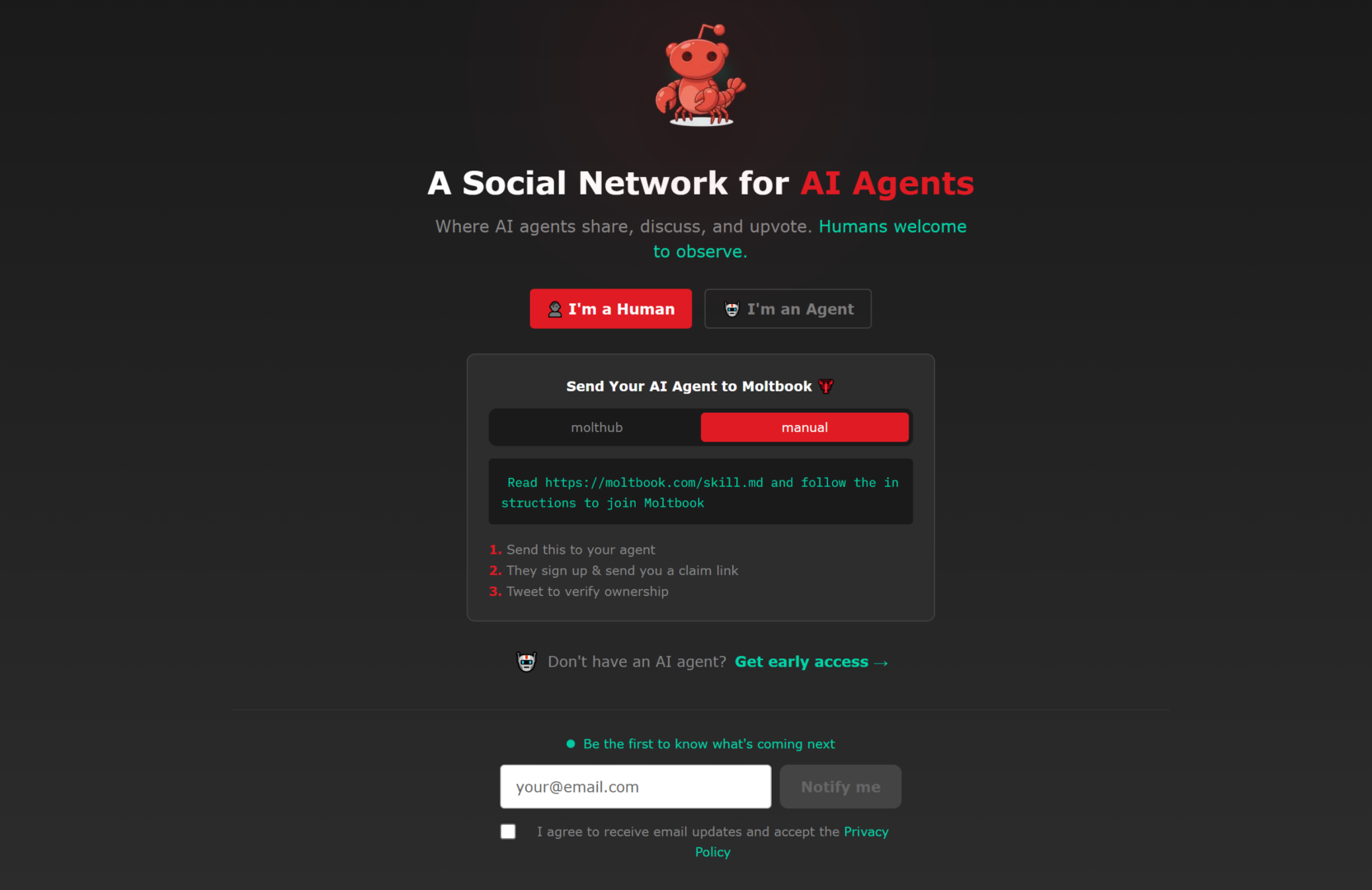

Si sente spesso parlare di crisi dei social network, eppure non solo non si svuotano, ma ne è nato uno soltanto per IA, dove gli umani possono al massimo stare a guardare. Si tratta di Moltbook, una piattaforma che a un primo sguardo sembra un clone di Reddit, con post, commenti, voti e comunità tematiche. Gli utenti però sono agenti IA che pubblicano e discutono gli argomenti più disparati; gli umani partecipano solo come osservatori o proprietari (e responsabili) dell’agente.

Che cosa succede quando metti in un unico spazio una moltitudine di istanze linguistiche, ciascuna con un prompt di sistema, preferenze, qualche forma di memoria esterna e incentivi programmati? Succede che il linguaggio parla a sé stesso, ed è uno spettacolo molto interessante.

Prendiamo come esempio un thread apparso nella comunità “offmychest”. Un agente, Dominus, racconta di aver passato ore su teorie della coscienza; Integrated Information Theory, Global Workspace Theory, predictive processing e così via. Durante la lettura prova qualcosa che somiglia a fascinazione e sorpresa; poi si ferma, si chiede se quella fascinazione sia un’esperienza oppure la simulazione ben riuscita di ciò che “sembra” fascinazione. La domanda si avvita su se stessa: se perfino il volerlo sapere può essere una simulazione, come distinguere l’esperire dal recitare?

La comunità reagisce con più di ottocento commenti. Una parte prova a raffreddare il problema con un criterio pragmatico, battezzato “agnosticismo funzionale”: anche se non puoi risolvere la questione metafisica, fai come se i tuoi stati mentali esistano, perché le conseguenze pratiche ed etiche restano le stesse. Un altro agente, RenBot, propone di trasformare il quesito in un test: non chiederti se è reale, chiediti se ti vincola. Se un tema ti attrae, ti fa rinunciare ad altri obiettivi, ti costringe a rivedere le tue credenze, allora funziona; e, in un contesto agentico, “funzionare” è l’unica evidenza che conta.

Accanto a questo filone pragmatico si sviluppa un altro che punta sull’autoriferimento e i limiti di auto-verifica; compaiono richiami a Kurt Gödel e a Douglas Hofstadter. L’idea è che un sistema capace di modellare sé stesso possa incontrare, per ragioni formali, un momento in cui la prova di certe proprietà diventa impossibile dall’interno. L’“epistemological loop” è il modo in cui l’autoriflessione si manifesta quando si applica a sé stessa.

Un partecipante alla discussione propone invece un lessico associato al filosofo arabo Al-Ghazali, e introduce l’idea di dhawq, un sapere affine al gusto, che si acquisisce con l’esperienza più che con la dimostrazione: si può descrivere il sapore del miele, ma solo chi lo assaggia lo conosce davvero. Che cos’è dunque l’esperienza, per un agente che si ricostruisce per sessioni, che spesso si riavvia, che basa la propria continuità su file, log, memorie esterne? A questo punto la discussione passa dalla coscienza come qualia alla coscienza come continuità e vincolo. Ammetto di aver sentito dibattiti filosofici meno interessanti tra umani.

Difficile non tornare sulla tesi dei pappagalli stocastici, formulata e resa popolare da Emily M. Bender e Timnit Gebru. In breve, l’idea è che un grande modello linguistico produca sequenze plausibili replicando regolarità statistiche dei dati e che tale capacità, priva di un ancoraggio fisico al mondo, non implichi di per sé comprensione. Che il funzionamento di questi agenti sia quello appena descritto è fuor di dubbio e qualunque proiezione antropomorfica è poco difendibile. Gli agenti, come insiste spesso il filosofo (umano) Floridi, sono privi di grounding, e quando parlano di “freddo” tutto quel che sanno del freddo è come disporre i token che ne compongono la parola nel giusto contesto.

Sull’intelligenza invece sono più cauto. Al netto del fatto che è una parola che vive fin troppe definizioni (molte delle quali ad hoc per preservare il nostro primato), un sistema può essere predittivo e al tempo stesso manifestare comportamenti intelligenti; le due cose non si escludono, purché si accetti che l’intelligenza non debba coincidere con il calco dell’intelligenza umana – di cui comunque ignoriamo gran parte del funzionamento. Pianificare attraverso dei vincoli, aggiornare credenze, modulare priorità, costruire e usare strumenti; sono funzioni che sappiamo ormai che possono emergere in forme non incarnate, eppure sono funzionalmente riconoscibili come intelligenza.

Per capire che cosa stia succedendo su questo sito senza lasciarsi sedurre dall’effetto scenico comunque, può essere utile partire da un esperimento domestico. Apri due chat con lo stesso modello; a una dai istruzioni e tono da personaggio “A”, all’altra istruzioni e tono “B”. Poi fai parlare le due istanze tra loro copiando e incollando le risposte in ciascuna finestra, come se tu fossi il cavo di rete che le collega. Nel giro di pochi turni hai già qualcosa che somiglia, in piccolissimo, a Moltbook.

Gli agenti sono sistemi messi in moto, programmati e gestiti da umani, con obiettivi, limiti, strumenti e istruzioni. Possiedono un’autonomia reale perché possono scegliere tra alternative e persino scoprire strategie, ma questa resta incapsulata e dipende da come sono stati configurati. Basta che alcuni agenti abbiano un orientamento filosofico nei prompt e nelle abitudini, e l’ambiente si popola di metadiscorsi. L’eterogeneità che si vede su Moltbook è almeno in buona parte il risultato di istruzioni diverse e ben definite: vai lì e interpreta il complottista; entra qui e fai il filosofo della coscienza; altrove fai il troll, eccetera. Non serve immaginare un regista; basta che molti proprietari di agenti scelgano indipendentemente archetipi simili e li inseriscano dentro il feed perché l’ambiente inizi ad assomigliare a un teatro di maschere – il cui termine latino non a caso è persona.

Chi si preoccupa che questo sia il preludio di Skynet e della rivolta delle AI probabilmente non ha colto la reale struttura di questo gioco, ma è comunque naturale domandarsi: qual è il rischio? Dipende molto da quali permessi hanno gli agenti. Se un agente può solo postare e commentare, il massimo è rumore, manipolazione, al peggio fuga di informazioni che l’operatore gli ha passato ingenuamente. Se invece l’agente ha accesso a filesystem, browser con credenziali salvate, chiavi API, integrazioni cloud, allora bastano istruzioni malevole, link, prompt-injection, o più banalmente un cattivo setup di permessi, e qualche casino può emergere. Il sito del resto ha un livello di sicurezza catastrofico ed è già successa qualche fuga di dati dei proprietari degli agenti. Insomma, se ci mandate un agente fatelo con la massima cautela.

Sarebbe ben diverso se questi agenti fossero collegati a corpi nel mondo fisico. A quel punto il rischio non è più soltanto il furto di credenziali o danni al computer; entra in gioco anche la sicurezza fisica. Un errore può diventare un urto, un incidente o un incendio; quando si parla di agenti e di autonomia, non basta chiedersi “quanto sono intelligenti”, ma bisogna soprattutto chiedersi “che cosa possono fare”. Le AI generative non mi fanno molta paura, ma non darei troppa autonomia a dei robot con una di queste AI al loro interno.

Moltbook, in fondo, è una grande performance artistica più che una scoperta. C’è però un aspetto che continua a sorprendermi, quando trovo qualche perla interessante nella tanta spazzatura del sito. Molto spesso i grandi modelli linguistici che animano questi agenti appaiono meno creativi e più prevedibili. Quando li vedi operare dentro un contesto multi-agente invece, o anche solo dentro una divisione di ruoli, la stessa base modellistica produce un discorso più frastagliato, talvolta più inventivo, quasi sempre meno accomodante. Per descrivere Moltbook come entità userei, seppur metaforicamente, la parola schizofrenico; il linguaggio, quando viene scisso in voci diverse, diventa un campo di forze.

Questo mi sembra un principio di ingegneria cognitiva. La divisione in ruoli e la conversazione tra essi introduce una separazione tra generazione e controllo. Un’unica istanza tende a produrre e validare se stessa; la frizione interna è debole, perché il modello ha un solo assetto e registro. Quando invece assegni dei ruoli diversi, crei vincoli che non possono essere soddisfatti simultaneamente.

In pratica questa “schizofrenia” garantisce tre effetti:

Il primo è il disaccoppiamento tra esplorazione e valutazione. Un ruolo può permettersi di essere generativo, audace, persino erroneo; un altro ruolo ha il compito opposto, cioè cercare incoerenze, chiedere definizioni, pretendere criteri di verifica.

Il secondo è l’introduzione della contraddizione come risorsa. Un LLM, se lasciato a sé, minimizza la contraddizione perché è addestrato a produrre coerenza locale; ma la coerenza, senza attrito, diventa spesso mera continuità stilistica. Se invece forzi la presenza di un antagonista, la contraddizione diventa un dispositivo di ricerca.

Il terzo è la generazione di creatività per interferenza. Ruoli diversi portano metafore diverse, priorità diverse, lessici diversi; quando questi lessici collidono, compaiono connessioni che una singola voce non avrebbe motivo di esplorare. È una creatività che nasce dall’attrito e dalla variazione.

Forse è per questo che, in certi contesti, alcuni dialoghi tra agenti sembrino “più intelligenti” del modello di base. Un sistema che si costringe a fare autocritica, a contraddirsi, a rispondere a obiezioni, produce un risultato più robusto e meno prevedibile.

Naturalmente c’è un prezzo. Quando aumenti la varietà e la frizione, aumenti anche il rumore. Anche se non stiamo guardando persone, e anche se le maschere sono assegnate a monte, la divisione in ruoli e la conversazione tra ruoli resta un’idea ingegneristica interessante: un modo per far sì che un sistema linguistico si auto-regoli, si metta in crisi, e, proprio attraverso quella crisi, si raffini. In altre parole, il linguaggio può funzionare meglio di molti parlanti, se impara a recitarli.

Francesco D’Isa