Il dibattito contemporaneo sulla post-verità sembra essersi ossessivamente concentrato sui deepfake, le immagini sintetiche capaci di simulare eventi inesistenti e falsi storici. Come suggeriscono vari studi e un’analisi attenta della storia dell’immagine però, si tratta di un fenomeno ampiamente sopravvalutato e di conseguenza molto meno comune di quanto si temeva; a diffondersi pare sia un processo diverso, che ho scelto di definire «deeptrue».

Rientrano in questa categoria le immagini false che ritraggono eventi reali, storicamente accaduti e verificabili; la loro resa visiva viene «migliorata», potenziata o ripulita tramite l’intervento dell’intelligenza artificiale generativa o di altre forme di fotoritocco. A differenza delle manipolazioni radicali che riscrivono la storia, i deeptrue mantengono un legame ontologico con l’accaduto; l’idea è quella di rendere più presentabile ed efficace l’immagine di un fatto, piuttosto che falsificarla.

Questo fenomeno si è manifestato con particolare chiarezza nel caso degli scontri avvenuti in occasione delle manifestazioni di protesta a Torino nel febbraio del 2026. Un’immagine diffusa dagli account social ufficiali della Polizia di Stato ritraeva un agente nell’atto di soccorrere un collega aggredito, tuttavia si trattava di un’immagine artificiale. Attraverso strumenti di restauro algoritmico, la scena è stata migliorata rispetto alla scarsa qualità del ritaglio tratto dal video originale.

Un’analoga iperbole estetica ha interessato le cronache delle nevicate record in Kamchatka nel gennaio dello stesso anno. Nonostante l’evento fosse autentico, la circolazione virale è stata alimentata da contenuti che esasperavano i fatti tramite l’intelligenza artificiale. Immagini di cumuli di neve alti quanto edifici di nove piani o di persone intente a scivolare da finestre poste ad altezze impossibili si sono affiancate velocemente a quelle reali e molti media sono caduti nell’inganno, dato che ogni verifica confermava che l’evento era realmente accaduto.

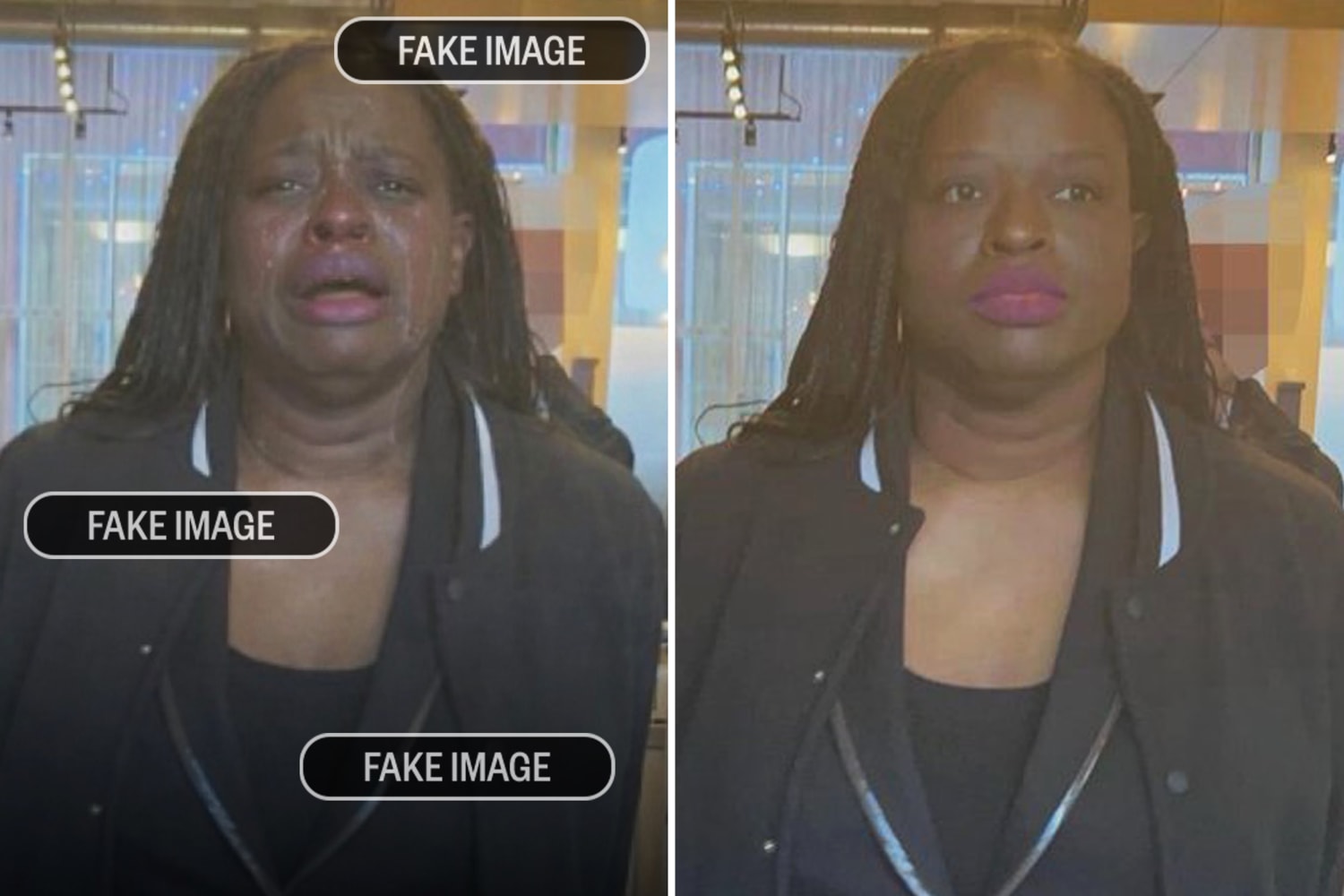

Un caso ibrido, sempre recente, emerge nell’episodio che ha coinvolto la Casa Bianca e l’arresto di Nekima Levy Armstrong da parte della famigerata polizia ICE. La fotografia originale mostrava la donna con un’espressione neutrale e composta, mentre la versione pubblicata dai canali ufficiali è stata modificata per farla apparire in lacrime. L’alterazione non smentisce l’arresto avvenuto, ma lo correda di un’emotività posticcia, funzionale a una specifica narrativa di sconfitta o debolezza dell’avversario. In questo caso però una falsificazione c’è stata e come spesso accade è stata velocemente scoperta, il che rende perlomeno dubbio il vantaggio ottenuto da un’istituzione come la Casa Bianca, che si è trovata puerilmente costretta a giustificare il suo uso di immagini platealmente false.

Susan Sontag osservava come la fotografia possieda da sempre il mandato di nobilitare il visibile; ogni oggetto o condizione, una volta inquadrati, tendono a diventare «interessanti» attraverso una precisa scelta autoriale. Nel celebre scatto della tazza del water di Edward Weston ad esempio, la nobilitazione deriva dalla decisione di isolare una forma elegante e solenne dal contesto prosaico. La fotografia analogica opera soprattutto per esclusione: il fotografo ritaglia un frammento di spazio-tempo scartando il resto e riduce l’immensità del reale a un istante ben definito.

Questa dinamica di selezione non riguarda solo l’autore dello scatto. Come analizza Zeynep Devrim Gürsel in Image Brokers, la circolazione delle immagini di cronaca è sempre stata mediata da figure professionali – editor, agenzie, archivisti – che agiscono come «broker» dell’immaginario. Questi intermediari costruiscono piuttosto quelle che Gürsel definisce «finzioni formative», visualizzazioni del mondo che devono risultare immediatamente leggibili e coerenti con le aspettative del pubblico globale. L’immagine giornalistica efficace è quella che meglio si adatta ai canoni narrativi preesistenti, quella che conferma un’iconografia del dolore, della vittoria o della crisi già metabolizzata dallo spettatore.

Per comprendere appieno la logica del deeptrue è necessario analizzare come la fotografia classica abbia anticipato l’azione algoritmica attraverso la manipolazione del contesto. Un esempio paradigmatico, analizzato dall’autrice, è lo scandalo che nel 2001 coinvolse il New York Times Magazine e il giornalista Michael Finkel. L’articolo, intitolato Is Youssouf Malé a Slave?, narrava la storia di un giovane maliano venduto in schiavitù nelle piantagioni di cacao. A corredo del testo campeggiava la fotografia di un ragazzo dall’aria sofferente che il pubblico identificò immediatamente con il protagonista.

Tuttavia il giovane ritratto non era affatto Youssouf Malé. Il giornalista Michael Finkel costruì un “personaggio composito”, fondendo le storie di diversi ragazzi in un unico archetipo narrativo. Per illustrarlo, non usò il vero Malé, ma la fotografia di un altro giovane, Madou Traoré, il cui volto possedeva la giusta aderenza visiva al ruolo di vittima, indipendentemente dalla sua identità anagrafica. Gürsel definisce queste operazioni delle finzioni formative: immagini che non servono a indicare un individuo specifico, ma a visualizzare una categoria politica (lo schiavo bambino, il rifugiato, ecc). La pratica editoriale descritta nel libro – che altrove porta a scartare immagini di palestinesi troppo bionde o vittime troppo moderne perché non conformi allo stereotipo – dimostra come pur senz alcuna immagine falsa il corpo reale venga modificato per coincidere con l’aspettativa del pubblico. Il deeptrue odierno automatizza questo processo: l’IA non ha bisogno di cercare il Madou Traoré di turno per mentire su Youssouf Malé; essa genera direttamente il “volto medio” della sofferenza.

Pensare che questo “volto medio” nasca con le intelligenze artificiali sarebbe però un errore, perché si era già palesato nel tardo Ottocento nel laboratorio di Francis Galton, cugino di Darwin e padre dell’eugenetica, il quale tentò di applicare la statistica al volto umano attraverso la tecnica della composite photography. L’obiettivo di Galton era scientificamente ambizioso quanto ideologicamente compromesso: voleva isolare le caratteristiche fisiognomiche della criminalità, della malattia o della salute sovrapponendo i ritratti di individui appartenenti alla medesima categoria.

Per farlo Galton fotografava una serie di soggetti (ad esempio, uomini condannati per crimini violenti) e poi esponeva le lastre una dopo l’altra su un unico foglio di carta fotografica, calcolando tempi di esposizione frazionati affinché ogni volto contribuisse in egual misura all’immagine finale. La sua aspettativa era vedere emergere un tipo mostruoso, una sorta di maschera del crimine che confermasse le teorie lombrosiane sulla devianza biologica.

Il risultato, tuttavia, non fu quello atteso. Il volto composito che emerse dalla camera oscura non era affatto un mostro; al contrario, appariva più bello, nobile e armonioso di ciascuno dei volti individuali che lo componevano. La sovrapposizione meccanica aveva agito come un filtro di pulizia estetica, in cui le asimmetrie, le imperfezioni cutanee e le irregolarità specifiche di ogni singolo criminale si erano annullate a vicenda, lasciando sopravvivere solo i tratti comuni. Galton aveva scoperto inavvertitamente che la media statistica, visivamente, coincide con la bellezza classica o, quantomeno, con l’assenza di difetti evidenti.

Qui viene in mente l’analisi che Lev Manovich ed Emanuele Arielli dedicano all’estetica dell’intelligenza artificiale. Com’è noto i modelli generativi apprendono la struttura statistica di miliardi di immagini per poi produrre nuovi esemplari che, per quanto nuovi e originali, tendono a collocarsi al centro della curva di distribuzione dei dati. Quando chiediamo a un algoritmo di generare o migliorare un volto, questo tende alla sua versione più probabile in base ai dati che ha assimilato. Il risultato è un’immagine che possiede una sorta di “bellezza statistica” che è un mix tra i nostri stereotipi estetici (per “nostri” intendo quelli presenti nel dataset) e una sorta di media visiva. È un’estetica levigata, dove ogni difetto tende a dissolversi. La realtà è piena di rumore, di dettagli inutili e accidentali. L’evento di Torino o la nevicata in Kamchatka diventano così più veri del vero proprio perché hanno perso la loro resistenza per diventare icone statisticamente perfette, pronte per essere consumate senza attrito.

Tale processo segnala quel che considero la natura più intima dell’immagine, quella di ideogramma. La foto del poliziotto di Torino più che la documentazione di uno specifico atto di soccorso è l’ideogramma della “solidarietà alla polizia” o della “violenza dei manifestanti”; la nevicata in Kamchatka abbandona la sua contingenza meteorologica per farsi simbolo assoluto della “neve da record”. La guerra tra ideogrammi è estetica, semantica e politica: non è un caso che il governo abbia cercato di imporre quell’ideogramma, contro quello (pur presente) di un manifestante malmenato dalla polizia.

Come ho scritto altrove, le relazioni tra immagini-ideogramma sono definite da attrattori semantici: centri di gravità concettuale che guidano le interpretazioni e i significati. Come la gravità fisica aggrega la materia, la gravità semantica compatta la realtà fenomenica in forme visive dense e immediatamente decifrabili. La natura dell’immagine non è di testimonianza quanto piuttosto una funzione linguistica, che significa più che descrivere il mondo con la massima efficienza possibile.

Come suggerisce Joan Fontcuberta nel suo La furia delle immagini, l’immagine post fotografica deve essere credibile piuttosto che vera. La verità fattuale si presenta spesso scialba, mal inquadrata o tecnicamente povera; la credibilità richiede invece una rigorosa aderenza ai codici visivi dominanti e alle aspettative del pubblico.

Il deeptrue risponde dunque a una necessità darwiniana. Se la fotografia originale dell’evento fosse visivamente confusa o sgranata, la sua capacità di circolare nelle reti sociali ne risulterebbe compromessa ed essa rischierebbe l’estinzione nel flusso torrenziale dei contenuti. L’intervento dell’intelligenza artificiale serve a garantire la fitness virale dell’oggetto iconico.

Questa pulsione a truccare il vero per renderlo credibile ha radici profonde nella storia dei media, come dimostra l’archetipo visivo del cormorano imbrattato di petrolio durante la Guerra del Golfo del 1991. Quell’immagine divenne istantaneamente il simbolo del disastro ecologico imputato a Saddam Hussein e orientò l’indignazione globale. Solo in seguito si apprese che il volatile era stato ripreso con ogni probabilità in un altro luogo e in un altro tempo e che la scena forse era stata allestita drammaturgicamente per le telecamere. La marea nera era un fatto reale e documentato; eppure la verità dei dati non bastava, necessitava di un attore — il cormorano — e di una scenografia efficace. Il deeptrue odierno è l’erede tecnologico di questa necessità: la realtà, per essere creduta e mobilitare le coscienze, deve prima imbellettarsi con un po’ di fondotinta.

Focalizzarsi esclusivamente sul ritocco o sulla veridicità forense rischia dunque di rivelarsi un diversivo che ci distoglie dal vero dispositivo di potere: quello che Judith Butler, in Frames of War, identifica come la violenza epistemologica del framing, una “produzione normativa dell’ontologia”. La cornice è ben lontana dall’inquadrare una realtà preesistente, perché decide quali vite siano degne di essere considerate tali e quali, invece, siano ridotte a scarti la cui distruzione non costituisce un crimine, perché non viene registrata come una perdita.

La “luttuosità” (grievability) è la precondizione politica della vita, che è considerata degna solo se è già iscritta nel registro di ciò che, nel futuro anteriore, sarà stato degno del nostro pianto. In questo senso, la fotografia di guerra è un regolatore del sentimento politico, che ci suggerisce quando e per chi provare orrore. Questa cornice, per imporre la sua egemonia e ratificare la norma, deve circolare, ripetersi e diffondersi incessantemente attraverso i media. Ma questa riproducibilità per Butler è anche il suo punto debole: nel transito da un contesto all’altro infatti, la cornice rischia costantemente di rompersi, di non riuscire più a contenere l’eccedenza del reale che cercava di escludere. È in queste crepe sistemiche — come avvenne con la circolazione virale delle foto delle torture di Abu Ghraib — che il rumore di fondo irrompe, svelando che l’immagine più che documentare la realtà, stava coercitivamente tentando di produrla.

Per cogliere il senso di deeptrue e deepfake, occorre analizzare il fallimento epistemico dell’immagine grezza, emerso con violenza durante il dibattito sull’uccisione di Renee Good da parte degli agenti ICE a Minneapolis. Il video dell’evento, ripreso da diverse angolazioni, era autentico e tecnicamente limpido; eppure l’opinione pubblica americana si è fratturata in due parti inconciliabili. Una parte del paese ha visto, con assoluta certezza, un SUV utilizzato come arma impropria per investire gli agenti; l’altra parte ha visto, con altrettanta indubitabile chiarezza, un’auto che tentava disperatamente di fuggire da una minaccia armata.

Si tratta di una riedizione politica del fenomeno virale noto come The Dress che nel 2015 divise il mondo tra chi vedeva un vestito blu e nero e chi lo percepiva bianco e oro. Come dimostrato dal neuroscienziato Pascal Wallisch, quella scissione dipendeva dal cervello: di fronte a un’illuminazione ambigua, il sistema visivo applicava dei priors (aspettative pregresse) per dedurre i colori. Chi assumeva inconsciamente che il vestito fosse in ombra lo vedeva bianco; chi lo immaginava sotto una luce artificiale lo vedeva blu.

Nel caso di Renee Good è accaduto lo stesso: l’identità politica ha agito come un correttore. Il sostenitore delle forze dell’ordine ha visto l’aggressione (il vestito bianco), l’attivista ha visto la fuga (il vestito blu). L’immagine si è rivelata un test di Rorschach in movimento dove ognuno ha proiettato le proprie credenze. Questa scissione percettiva trova una spiegazione nella teoria della Cultural Cognition elaborata da Dan Kahan. Le ricerche di Kahan dimostrano che gli individui tendono a interpretare le informazioni in modo da proteggere la propria appartenenza al gruppo sociale di riferimento. È quello che viene definito identity-protective cognition: il cervello accetta come “vero” solo ciò che non mette a rischio la sua posizione all’interno della tribù politica. Nel caso del video di Renee Good, l’ambiguità visiva viene risolta istantaneamente da questo meccanismo di difesa identitaria.

I deeptrue come strumento per perpetrare un inganno sono deboli – d’altra parte indicano il vero – e la loro natura è più simile a quella di un vecchio, abuso dispositivo di retorica visiva, seppur in salsa contemporanea. Le immagini in fondo non indicano il mondo – lo smuovono.

Francesco D’Isa

Bibliografia e Riferimenti

AFP Fact Check. “Footage of massive snowfall in Kamchatka is AI-generated.” 29 gennaio 2026. https://factcheck.afp.com/doc.afp.com.94984G3.

Alvich, Velia. “La Casa Bianca ha usato l’intelligenza artificiale per aggiungere lacrime finte alla foto di una donna in manette.” Corriere della Sera, 23 gennaio 2026. https://www.corriere.it/tecnologia/26_gennaio_23/la-casa-bianca-ha-usato-l-intelligenza-artificiale-per-aggiungere-lacrime-finte-alla-foto-di-una-donna-in-manette.shtml.

Associated Press. “Police Arrest Protesters at Minneapolis Federal Building on 1-Month Anniversary of Woman’s Death.” AP News, 7 febbraio 2026. https://apnews.com/article/8cf815a6c4b20f1f79874d65c9f1361f.

Barari, Soubhik, Christopher Lucas, e Kevin Munger. “Political Deepfakes Are as Credible as Other Fake Media and (Sometimes) Real Media.” The Journal of Politics 87, n. 2 (2025): 510-526

BBC News. “Video filmed by ICE agent who shot Minneapolis woman emerges.” Video YouTube, 0:54. Pubblicato il 1 ottobre 2024. https://www.youtube.com/watch?v=bcOfsg749Wk.

Butler, Judith. Frames of War: When Is Life Grievable? London: Verso, 2009.

Capoccia, Francesca. “Il TG1 ha pubblicato un video sulle nevicate in Kamchatka fatto con l’IA.” Facta, 20 gennaio 2026. https://www.facta.news/articoli/tg1-video-nevicate-kamchatka-russia-intelligenza-artificiale.

D’Isa, Francesco. “Deepfake: anatomia di una paura.” The Bunker, 12 novembre 2025. https://www.the-bunker.it/rubrica/deepfake-anatomia-di-una-paura/.

D’Isa, Francesco. La rivoluzione algoritmica delle immagini: Arte e intelligenza artificiale. Roma: Luca Sossella Editore, 2024.

Du Sautoy, Marcus. The Creativity Code: Art and Innovation in the Age of AI. Cambridge, MA: Belknap Press of Harvard University Press, 2019.

European Journalism Observatory. “Fakes in Journalism.” Consultato il 12 febbraio 2026. https://en.ejo.ch/ethics-quality/fakes-in-journalism.

Finkel, Michael. “Is Youssouf Malé a Slave?” The New York Times Magazine, 18 novembre 2001. https://www.nytimes.com/2001/11/18/magazine/is-youssouf-male-a-slave.html.

Fontcuberta, Joan. La furia delle immagini: Note sulla postfotografia. Tradotto da Sergio Giusti. Torino: Einaudi, 2018.

Gürsel, Zeynep Devrim. Image Brokers: Visualizing World News in the Age of Digital Circulation. Oakland: University of California Press, 2016.

Hannon, Elliot, e Ben Mathis-Lilley. “The Great Blue and Black Versus White and Gold Dress Debate.” Slate, 27 febbraio 2015. https://www.slate.com/blogs/the_slatest/2015/02/26/the_great_blue_and_black_versus_white_and_gold_dress_debate.html.

Kahan, Dan M. “Cultural Cognition as a Conception of the Cultural Theory of Risk.” In Handbook of Risk Theory, a cura di Sabine Roeser et al., 725–759. Dordrecht: Springer, 2012.

Langlois, Judith H., e Lori A. Roggman. “Attractive Faces Are Only Average.” Psychological Science 1, no. 2 (1990): 115–121.

Levine, Sam. “White House Posts Digitally Altered Image of Woman Arrested after ICE Protest.” The Guardian, 22 gennaio 2026. https://www.theguardian.com/us-news/2026/jan/22/white-house-ice-protest-arrest-altered-image.

Manovich, Lev, e Emanuele Arielli. Estetica artificiale: IA generativa, arte e media. Roma: Luca Sossella Editore, 2026.

Pisa, Pier Luigi. “Scontri a Torino, la foto degli agenti aggrediti è IA. Polizia: ‘Presa dal web, non è opera nostra’.” la Repubblica, 6 febbraio 2026. https://www.repubblica.it/tecnologia/2026/02/06/news/foto_polizia_generata_ia_scontri_torino-425143065/.

Sky TG24. “Scontri Askatasuna a Torino, Polizia pubblica foto agente aggredito modificata con AI.” 6 febbraio 2026. https://tg24.sky.it/cronaca/2026/02/06/scontri-askatasuna-torino-polizia-foto-ai.

Sontag, Susan. Sulla fotografia: realtà e immagine nella nostra società. Torino: Einaudi, 2004.

Wallisch, Pascal. “Illumination assumptions account for individual differences in the perceptual interpretation of a profoundly ambiguous stimulus in the color domain: ‘The dress’.” Journal of Vision 17, no. 5 (2017): 5.