Diritti Digitali della Società Locale e Globale

di Fabio Gnassi

I modi d’uso e i processi integrativi delle tecnologie che utilizziamo quotidianamente sembrano plasmarsi e plasmarci unicamente attraverso le interfacce informatiche ed estetiche che filtrano l’interazione utente-strumento. Eppure sono i piani normativi, etici e legislativi a dover essere al centro dei processi di educazione, formazione e modellazione dello sviluppo delle tecnologie che utilizziamo.

In questa intervista Fabio Gnassi, a nome della Redazione di The Bunker, intervista la giurista, imprenditrice ed attivista Luna Bianchi attorno L’Ai Act e il ruolo delle normative nell’interazione tra società e tecnologia.

La tempestività con cui le istituzioni si affrettano a regolamentare l’utilizzo della nuove tecnologie, evidenzia la capacità di quest’ultime di interagire e di plasmare gli aspetti profondi della società.

Qual è la sua visione sul binomio tecnologia e legislazione?

Sia la tecnologia sia il diritto sono costruzioni sociali, frutto cioè di un processo esclusivamente umano, di una negoziazione sociale spesso capace di smontare e reindirizzare gli interessi e le istanze che le avevano inizialmente create. Innanzitutto, perché è la società a definire i presupposti per lo sviluppo di una determinata tecnologia e di un determinato framework normativo, scegliendo quali gruppi sociali tutelare, a quali istanze ed esigenze rispondere e da quali interessi farsi guidare.

Ma anche perchè entrambe modellano la società a cui sono applicate: influenzano e prescrivono comportamenti specifici agli individui e alle collettività che ne sono soggette, contribuendo a definirne i ruoli e, sostanzialmente, la forma politica.

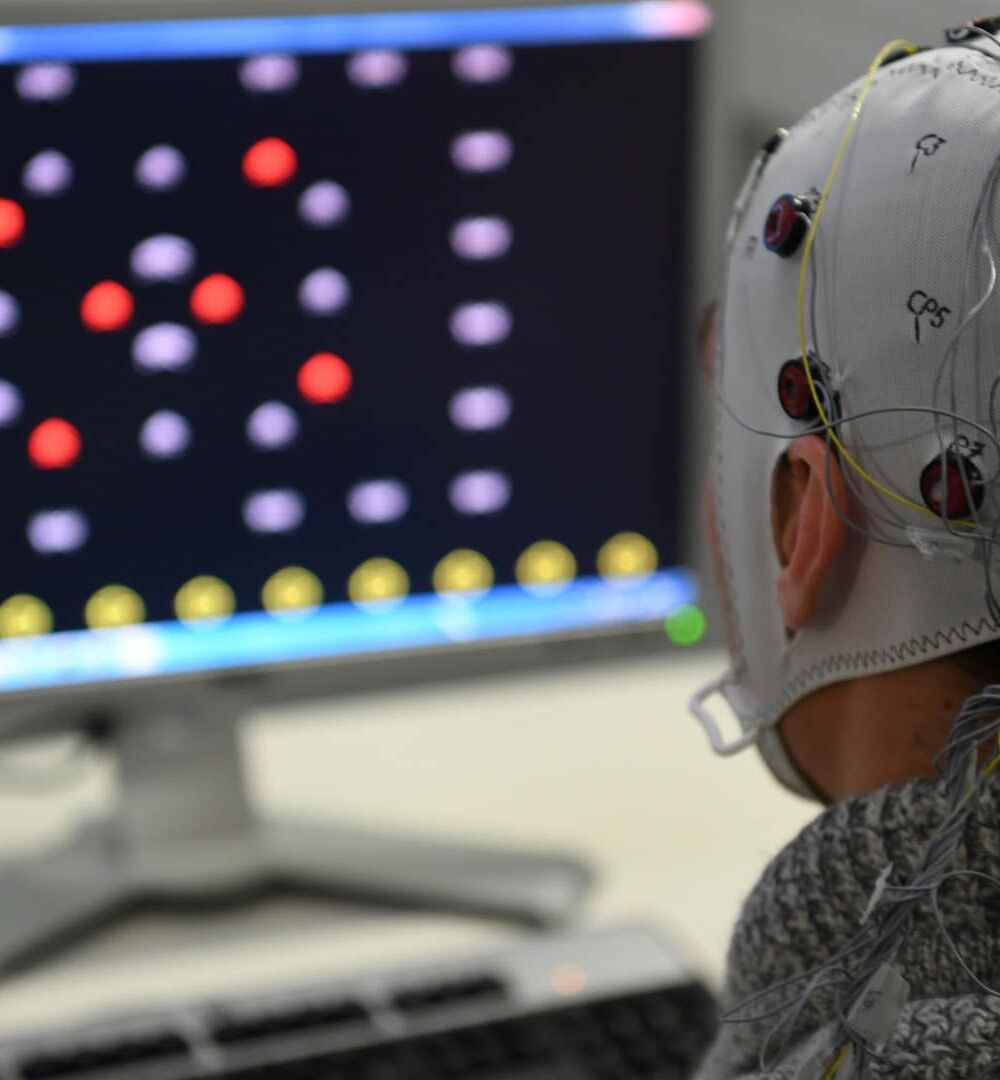

Lawrence Lessing scriveva già nel 2006 “code is law”, gli algoritmi oggi contribuiscono a regolare la società esattamente come il diritto, stabilendo comportamenti e definendo le modalità in cui si è (cioè si esiste e si è riconosciuti nella propria identità) e si vive in un determinato spazio. A differenza dalla legge però, un codice algoritmico ha un impatto, massivo e immediato, sulla comunità a prescindere dall’essere noto o visibile, e questo crea un cortocircuito rispetto alla nostra capacità di partecipare a quella negoziazione sociale che permette anche a tecnologia e diritto di evolvere con il contesto a cui sono applicate.

Sia la tecnologia sia il diritto sono costruzioni sociali, frutto cioè di un processo esclusivamente umano, di una negoziazione sociale spesso capace di smontare e reindirizzare gli interessi e le istanze che le avevano inizialmente create.

Un’efficace integrazione dell’intelligenza artificiale in ambito sociale, richiede non solo un quadro normativo adeguato, ma anche un piano divulgativo altrettanto appropriato.

Quali principi, a suo avviso, dovrebbero essere posti alla base di un progetto educativo in questo ambito?

Innanzitutto, proprio che la tecnologia non è neutra ma essenzialmente politica, è una costruzione della società, quindi anche nelle nostre mani. Ciò significa che sono le scelte degli esseri umani che la commissionano, sviluppano, implementano ed usano a determinare quanto e come quella tecnologia influenzerà la forma della società.

Questa consapevolezza è fondamentale, soprattutto se legata a ciò che a queste scelte consegue, e quindi gli impatti che la tecnologia ha su di noi, nella nostra dimensione individuale e collettiva. Tali impatti infatti, possono essere massivi, e non per altro l’AI Act (regolamento europeo sull’intelligenza artificiale) insiste proprio su questo punto: l’IA comporta degli impatti e dei rischi specifici, nuovi e potenzialmente dannosi che vanno governati e gestiti adeguatamente. Il secondo punto quindi, ruota intorno alla necessità di non essere ingenui di fronte all’adozione dell’IA.

Non esserne spaventati, perché è una tecnologia che fa completamente parte della nostra vita ormai (anche quando spesso non ce ne accorgiamo), ma neanche facilmente entusiasti, assimilandola ad una qualsiasi innovazione precedente. L’IA ha una capacità di influenza di cui spesso non siamo coscienti, e introdurre un’IA in un contesto, in un processo, cambia lo stato stesso di quel contesto e di quel processo. L’IA non cambia solo il modo in cui facciamo le cose, ma anche come le pensiamo e progettiamo, intervenendo ed hackerando molti dei concetti, delle strutture e dei movimenti che conosciamo. Per questo è così importante da una parte esercitarci a guardare ciò che già conosciamo con occhi nuovi, per vedere quanto alcune strutture necessitino di essere trasformate per rispondere al nuovo contesto socio-tecnico (ad esempio alcuni impianti normativi), e dall’altra impegnarsi per applicare un sistema di etica rafforzata quando ci interfacciamo con l’IA per rendere il processo decisionale della macchina più simile a quello umano, perché possa tenere insieme anche la complessità e i valori umani e l’esperienza che noi abbiamo del mondo. Credo che questi siano i principi mentali sui quali concentrarci oggi, per essere pronti a svilupparne di nuovi domani.

L’AI è un fenomeno di natura planetaria che va oltre le implicazioni culturali, sociali e politiche dei singoli stati. L’Unione Europea è tra le prime organizzazioni politiche ad aver sviluppato una propria regolamentazione in materia di IA. Che valore dà a questa normativa e quale pensa potrà essere il suo ruolo all’interno di un più ampio accordo internazionale?

Quello a cui stiamo assistendo in questa prima fase dell’AI Act è il cosiddetto “Brussels Effect”, la capacità cioè dell’Europa di influenzare la legislazione internazionale in un mondo globalizzato. L’impianto basato sugli impatti e sui rischi dell’AI Act è infatti la base delle altre legislazioni che si stanno diffondendo in molti paesi, USA Canada, UK Brasile, India, Cina Indonesia Nuova Zelanda Perù, Singapore, Taiwan. Il nodo da sciogliere sarà però legato alle dinamiche di potere tra soggetti privati e istituzioni: chi controllerà l’IA? Con il GDPR abbiamo assistito ad una sostanziale disertazione delle big tech (e non solo), c’è da chiedersi oggi con l’IA se saremo capaci di far rispettare l’AI Act nella sua ratio di fondo, modificando l’approccio stesso che abbiamo all’innovazione.

Perché le leggi possono essere anche adeguate e coraggiose (che non è al 100% il caso dell’AI Act, anche a causa dell’immensa lobby esercitata proprio dalle big tech che hanno fatto arretrare il Parlamento europeo su diverse questioni centrali, come il riconoscimento biometrico), ma se manca un reale enforcement delle stesse non servono a nulla se non a creare una situazione di stallo e frustrazione degli utenti/cittadini. Intorno all’IA si è creata una tale concentrazione di potere, e di mercato, che è ormai urgente rivedere le normative antitrust: non abbiamo ad oggi istituti sufficientemente efficaci per tenere a bada questo sistema mono/oligopolista. Allora si rende necessario capire come ripensare alla governance e, alla fine, ai processi decisionali pubblici nel loro complesso, capendo come la forza (economica, politica, di influenza) dei privati possa essere bilanciata con gli interessi, e responsabilità, pubblici delle istituzioni.

Gli stati europei sono caratterizzati da un particolare paradosso, che associa la difficoltà di assimilare ciò che viene percepito come nuovo ad un’elevata propensione verso la costruzione dirigidi quadri normativi, che invece di incentivarne lo sviluppo ne limitano l’adozione.

Qual è il suo pensiero a riguardo?

In questa fase storica di grande rivoluzione sociale e tecnica dovremmo ricercare non tanto un nuovo assetto rigido e codificato, ma anzi strumenti che favoriscano la negoziazione sociale per il continuo adattamento di tecnologie e diritti alle mutate, e specifiche, condizioni socio economiche politiche e culturali. Credo che il segreto sia proprio quello di trovare soluzioni flessibili che permettano di tradurre gli obiettivi e i valori degli artefatti rispetto alle reali necessità emergenti, di bilanciare gli interessi e i diritti sulla base delle contingenze reali. Cosa significa giustizia in questo contesto? Chi va tutelato? Di che tipo di innovazione abbiamo bisogno per migliorare le condizioni della nostra società nel suo complesso, partendo da chi è più svantaggiato?

Anche la tecnologia quindi, come il diritto, dovrebbe – e così è richiesto dall’AI Act – condurre specifiche valutazioni di impatto prima del rilascio sul mercato, assicurandosi di pianificare adeguate strategie di gestione dei rischi, anche etici, che emergono dall’introduzione in un determinato contesto di una tecnologia. Se ancora oggi le nuove tecnologie, pensiamo all’IA generativa, ci vengono date in pasto senza una sufficiente analisi ex-ante di quelle che possono essere le conseguenze che ne derivano, possiamo essere certi che questa sia una scelta che ha un significato molto preciso e un indirizzo politico identificabile proprio nella lotta di potere cui stiamo assistendo che certamente non mira alla reale tutela o al benessere degli esseri umani.

![The Topologies of Zelda Triforce (Patrick LeMieux, Stephanie Boluk, 2018) [image from itchio]](https://www.the-bunker.it/wp-content/uploads/2025/06/The-Topologies-of-Zelda-Triforce-Patrick-LeMieux-Stephanie-Boluk-2018-image-from-itchio-thegem-product-justified-square-double-page-l.jpg)