LA RIVOLUZIONE ALGORITMICA

Chi controlla la macchina

di Francesco D'Isa

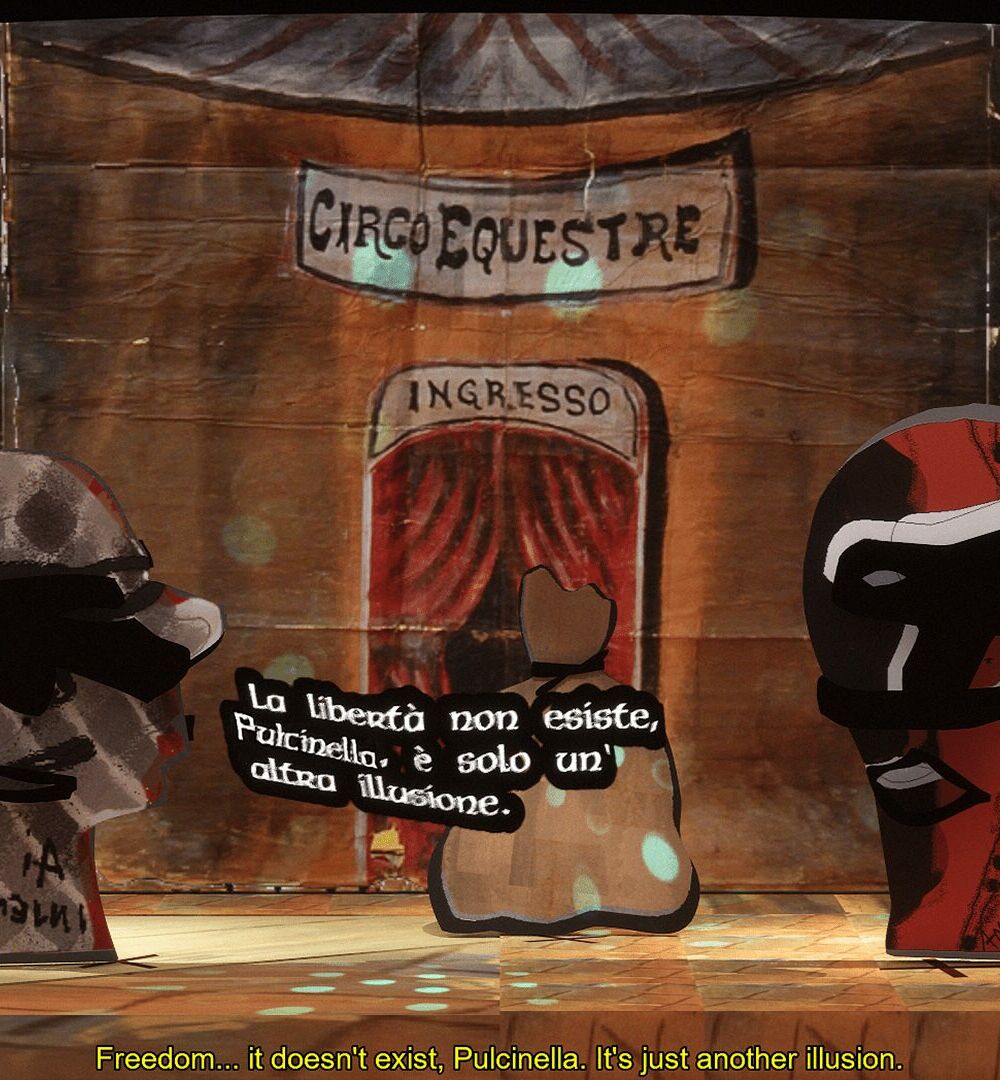

Uno sguardo critico e filosofico sull’intelligenza artificiale e la sua influenza su società, cultura e arte. La rivoluzione algoritmica si propone di esplorare il ruolo dell’AI come strumento o co-creatore, interrogando i suoi limiti e potenzialità nella trasformazione dei processi conoscitivi ed espressivi.

Ogni volta che un progetto nato con l’IA generativa ottiene una qualche visibilità, la polarizzazione è immancabile: da un lato chi intravede la democratizzazione della conoscenza, dall’altro chi grida all’ennesima espropriazione capitalistica. Non occorre citare un caso specifico, perché si tratta ormai del frame predefinito con cui la sfera pubblica accoglie qualunque produzione mediata dall’IA.

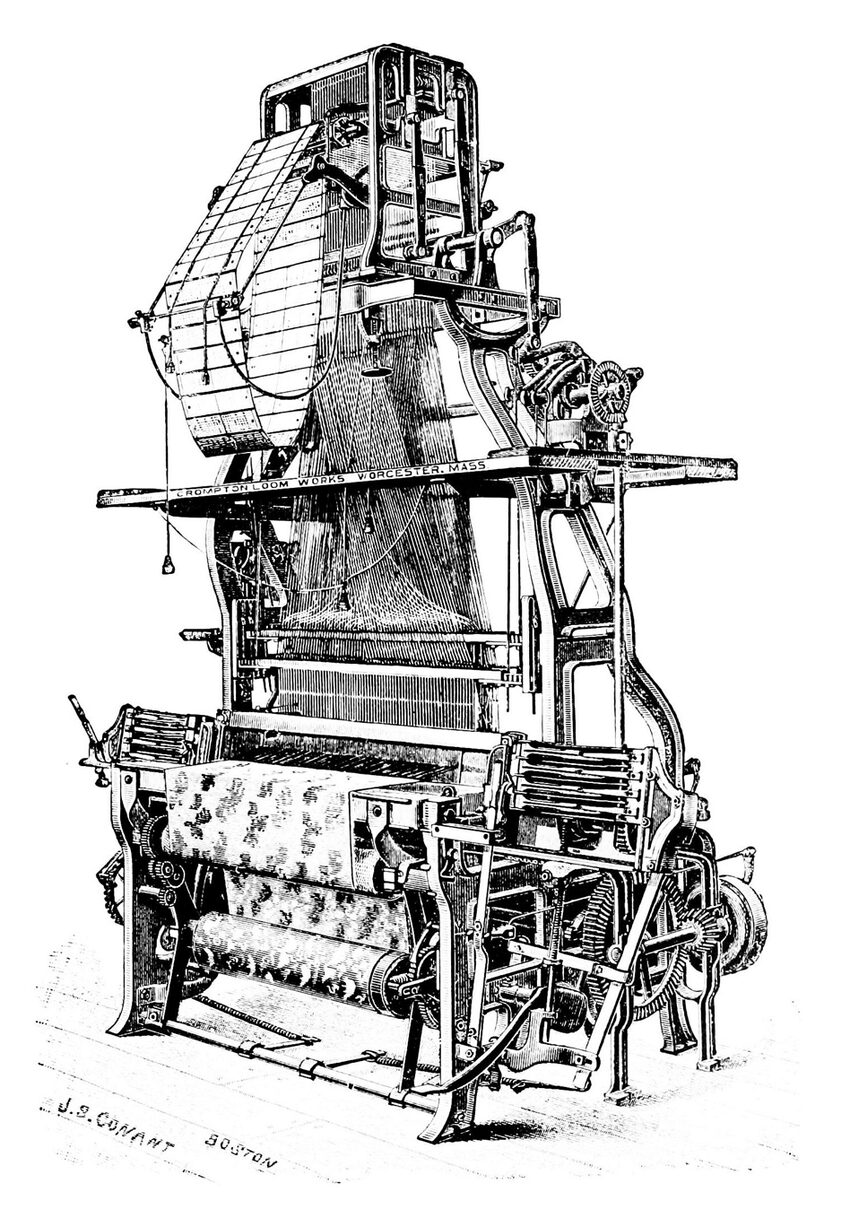

Non è una novità; due secoli fa, i tessitori luddisti di Nottingham rompevano i telai non per odio del progresso, ma per chiedere che la macchina non diventasse strumento di dumping salariale. La stessa dinamica, come ricorda di recente John Cassidy sul New Yorker, riappare oggi con altri attori ma identiche paure. Il problema, ancora una volta, non è la macchina in sé, bensì la regia politica ed economica che ne decide usi e soprattutto i ricavi. A pungolare le barricate, un dilemma: se boicottare lo strumento e chi lo utilizza o apprenderlo e metterlo a frutto.

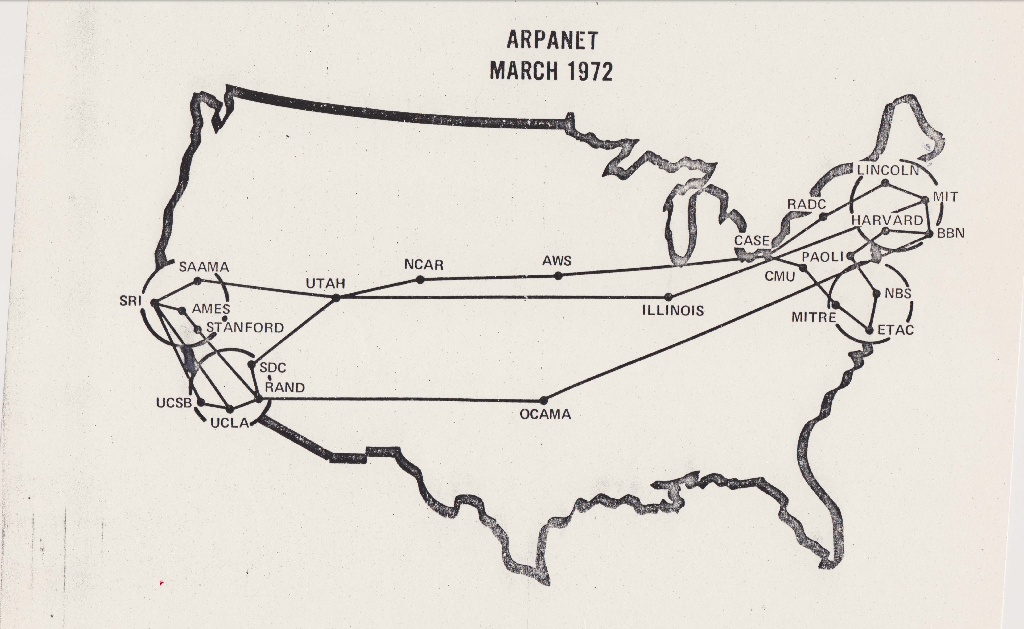

Le tecnologie che Lipsey, Carlaw e Bekar chiamano general purpose technologies – quei dispositivi o infrastrutture che, una volta apparsi, si diffondono orizzontalmente in ogni settore – hanno una peculiarità implacabile: rendono proibitivo il costo di restarne fuori. La storia dell’elettricità lo illustra in modo quasi didattico. Quando alla fine dell’Ottocento il sistema di Edison vincolava lampadine, contatori e generatori a un’architettura proprietaria, nessuna città poteva permettersi di restare al buio in attesa di un’alternativa; via via che le reti si estendevano, l’accesso alla corrente diventava condizione per la stessa sopravvivenza economica e fu questa necessità – non un tratto morale – a spingere i municipi a negoziare tariffe o a creare utility pubbliche, come ricostruisce Thomas P. Hughes in Networks of Power. Lo stesso schema si ripete con il calcolo elettronico: dai mainframe governativi agli home computer descritti da Paul Ceruzzi, chi voleva restare competitivo in ricerca, grafica e contabilità, non poteva ignorare quel nuovo modo di trattare l’informazione; il prezzo dell’astensione cresceva con ogni software che diventava standard de facto. Poi arrivò Internet, e Benkler ha mostrato come i network effects obbligassero individui e imprese a connettersi pur sapendo che la dorsale fisica era in mano a pochi operatori; la rete era già l’agorà globale, e rinunciarvi significava auto‑marginalizzarsi.

L’algoritmo generativo si colloca sulla stessa traiettoria: è probabile che le sue notevoli potenzialità ne faranno un bene infrastrutturale, più che uno strumento opzionale – e in molti casi già lo è. Possiamo discutere a lungo sull’opacità dei dataset o sui sistemi proprietari e monopolistici, ma mentre lo facciamo università, studi legali, aziende, giornali e singoli utenti ne integrano le funzionalità nei flussi di lavoro quotidiani. Chi immagina di boicottare l’IA perché “nata sbagliata” si troverà presto nelle condizioni di un lavoratore del terziario che rifiuti l’uso di internet.

In tempi che sembrano ormai lontanissimi, Gramsci ci ricordava che la tecnica non è mai un ambito neutro distinto dalla cultura. Nel Quaderno 12 annota che «non c’è attività umana da cui si possa escludere ogni intervento intellettuale, non si può separare l’homo faber dall’homo sapiens»: se la riflessione intellettuale coinvolge ogni gesto produttivo, l’alfabetizzazione tecnica diventa condizione di ogni azione politica efficace. Nelle pagine de L’Ordine Nuovo, Gramsci scrive: «Le innovazioni industriali […] permettono all’operaio una maggiore autonomia, lo collocano in una superiore posizione industriale […] La classe operaia si stringe intorno alle macchine, crea i suoi istituti rappresentativi come funzione del lavoro, come funzione della conquistata autonomia, della conquistata coscienza di autogoverno» (14 febbraio 1920). In altre parole, la macchina diventa fattore emancipativo solo quando i lavoratori ne conquistano la gestione collettiva. Nello stesso giornale, pochi mesi prima, insisteva: «Imponendo il controllo operaio sull’industria, il proletariato […] impedirà che l’industria e la banca sfruttino i contadini e li soggioghino come schiavi alle casseforti». (3 gennaio 1920). Tecnica, quindi, come terreno di lotta: padroneggiandola, il lavoro organizzato sottrae la forza produttiva all’estrazione di rendita e la orienta verso fini sociali. Non è dunque la macchina in sé a determinare la subordinazione, ma la regia che ne dirige i ritmi e ne incamera i profitti. Da qui prende forma la figura dell’intellettuale organico: non un chierico separato, bensì un tecnico‑organizzatore capace di congiungere competenza operativa e progetto collettivo. In questa prospettiva, l’intelligenza artificiale non è un gadget da idolatrare o respingere, bensì il terreno sul quale una nuova soggettività può misurare la propria capacità di governare le forze produttive e trasformarle in senso emancipativo. L’esigenza diventa capire e impadronirsi dello strumento. È così più chiaro cosa intedeva il pioniere dell’intelligenza artificiale Geoffrey Hinton durante una recente intervista, quando, alla domanda su quali politiche economiche fossero necessarie per far sì che l’A.I. funzionasse per tutti, ha risposto con una sola parola: “Socialismo”.

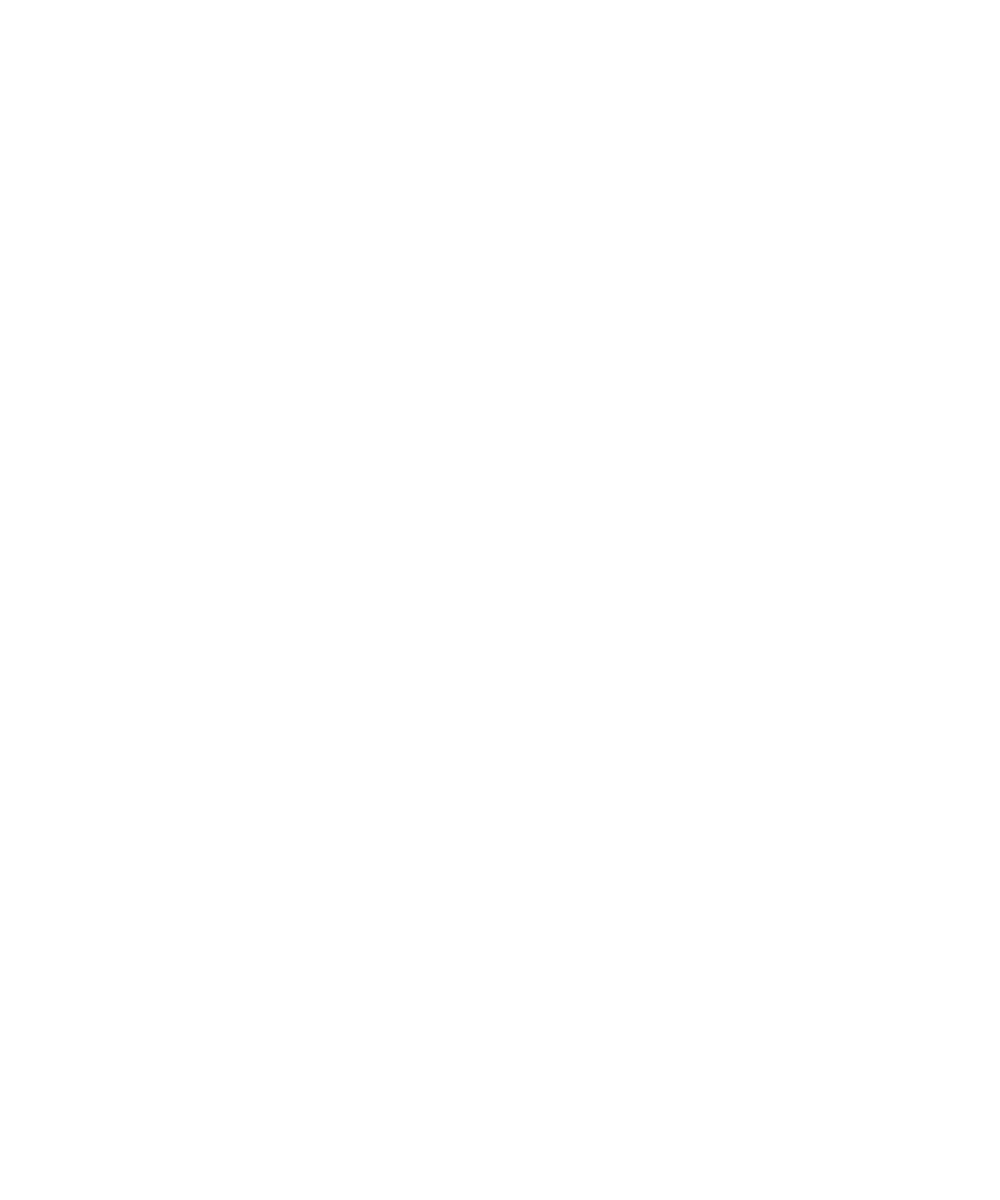

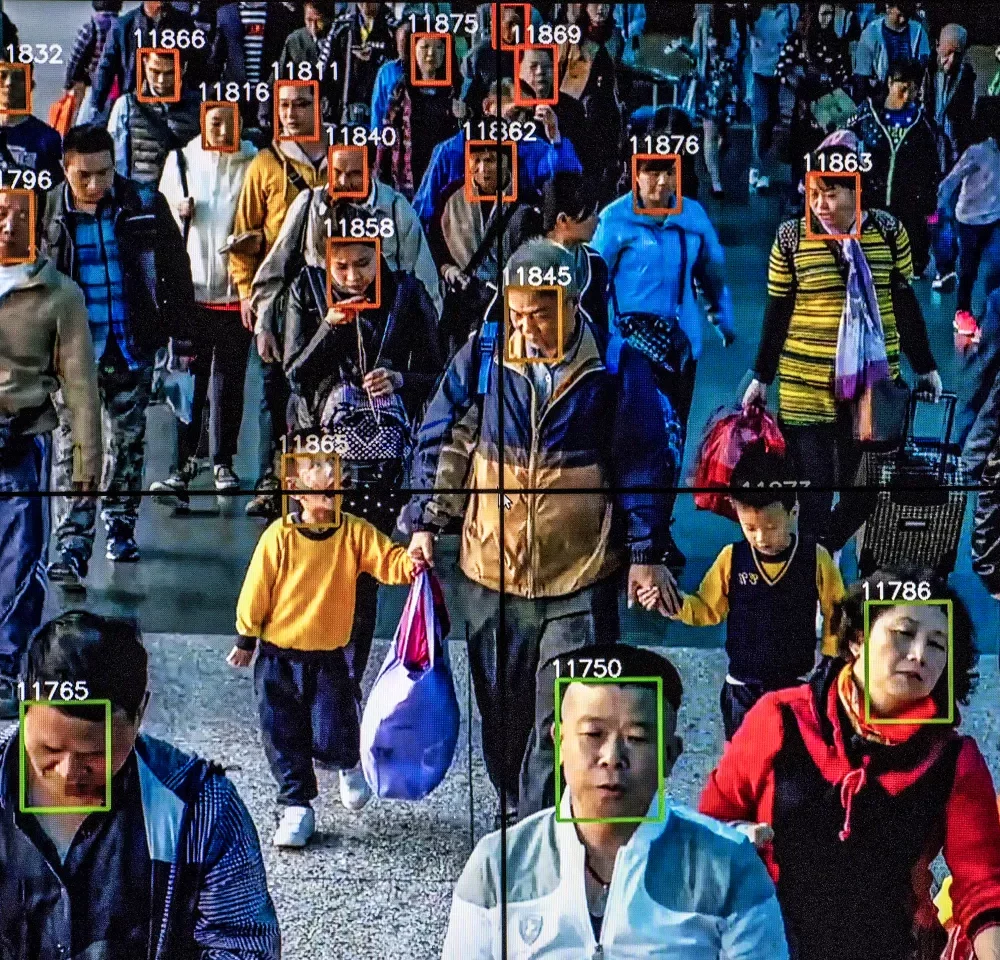

Il dibattito sull’IA generativa sembra invece intrappolato in un déjà‑vu culturale che Kirsten Drotner, studiando la storia dei mass‑media, chiama media panic: un ciclo emotivo in cui ogni nuovo mezzo viene accusato di corrompere i giovani, distruggere il lavoro, sovvertire la verità. Drotner mostrava già negli anni Novanta che il panico segue una coreografia ricorrente: identificazione di un “gruppo vulnerabile”, moltiplicazione di titoli allarmistici, richiesta di misure drastiche e, infine, assestamento del mezzo dentro la vita quotidiana. Lo stesso copione si è ripetuto dal romanzo popolare ottocentesco ai fumetti, dalla TV ai videogiochi; oggi basta evocare la parola “deepfake” o l’etichetta “AI‑slop” perché la retorica collassi di nuovo sull’idea di un’imminente catastrofe cognitiva. Eppure, come osservavano anche Goode e Ben‑Yehuda, il panico funziona più da rito di stabilizzazione simbolica che da analisi dei rischi reali: serve a sollevare dal tavolo la questione dei rapporti di potere che strutturano il mezzo, spostando l’attenzione dalla proprietà delle piattaforme alla moralità degli utenti. Nel mirino finiscono così i generatori di immagini “troppo facili”, le canzoni composte “senza talento”, gli articoli “scritti dal robot” – di rado le catene di brevetti, i monopoli, lo sfruttamento sistemico che rende possibile l’automatismo. Il risultato è un corto circuito: più si demonizza la tecnologia, meno si discute di governance e redistribuzione, lasciando i nodi strutturali intatti. Riconoscere il media panic non significa minimizzare i problemi, ma togliere al panico la sua funzione paralizzante, per restituire alla politica – e non alla psicosi collettiva – il compito di decidere chi e come deve governare l’intelligenza artificiale.

Matteo Pasquinelli nel suo Eye of the Master propone di affrontare l’intelligenza artificiale con gli occhiali di una “labour theory of automation”: dietro l’algoritmo che sembra funzionare da solo si distende una catena di lavoro in carne e ossa ‒ annotatori che etichettano miliardi di immagini a pochi centesimi, moderatori che filtrano contenuti tossici, tecnici che sorvegliano i data‑center ventiquattr’ore su ventiquattro, comunità che forniscono gratis il proprio parlato per addestrare modelli vocali. Senza questi gesti la macchina non funziona. Anche la potenza di calcolo non è un fatto astratto: le GPU che macinano parametri richiedono (come ovviamente gran parte della nostra tecnologia) miniere e centrali elettriche, spostano carichi di lavoro verso paesi dove l’energia costa poco e la regolazione ambientale è debole, ridisegnano geografie industriali e alleanze geopolitiche. Per Pasquinelli, quindi, il primo compito critico è riportare in primo piano la forza‑lavoro che ne costituisce l’anima nascosta; se l’automazione è un processo di astrazione del lavoro, l’unico modo per riportarlo alla realtà è ri‑materializzarlo in tutte le sue fasi.

Da questa diagnosi è mia opinione che la strategia più efficace non passi per il boicottaggio, bensì per la riappropriazione. Significa dare volti, salari e diritti a chi addestra e cura i modelli, organizzare forme di sindacalizzazione dell’annotazione, pretendere contratti che riconoscano l’autorialità collettiva dei dataset e di conseguenza l’apertura del risultato. Significa anche aprire audit indipendenti sui pesi e sui log di addestramento, per rompere l’opacità proprietaria che trasforma una risorsa pubblica di conoscenza sedimentata (libri, forum, archivi sonori) in merce privata. E ancora: rivendicare infrastrutture energetiche meno predatorie, magari finanziate da consorzi pubblici di GPU, in modo che la potenza di calcolo sia considerata come un servizio essenziale al pari dell’acqua o del trasporto urbano. Queste e altre iniziative devono far sì che la forza produttiva racchiusa nell’IA possa smettere di essere rendita per pochi e diventare una risorsa condivisa.

Se la posta in gioco è contendere alle big tech il possesso assoluto del mezzo, la porta d’ingresso è l’apertura del codice. Lungo questa traiettoria, esistono per fortuna casi concreti: sul fronte testuale il modello DeepSeek‑LLM, diffuso in versioni da sette e sessantasette miliardi di parametri, è arrivato completo di pesi, pronto per essere riaddestrato; Mistral ha rilanciato con la sua serie 7 B, licenza Apache 2.0, cioè libertà piena di studio, modifica e impiego anche commerciale. Nell’universo delle TTI, il software Stable Diffusion ha già dimostrato che pubblicare ogni riga di codice può far fiorire migliaia di fork indipendenti e un percorso analogo (ma parziale) vale per Flux, modello da 12 miliardi di parametri sviluppato da Black Forest Lab. Eppure l’open‑source, da solo, forse non basta: per evitare che le stesse corporation succhino valore ai commons servirebbe un recinto giuridico come il copyfarleft di Dmytri Kleiner, che autorizza l’uso interno a comunità cooperative e obbliga chi lucra privatamente a riversare le migliorie nel dominio comune. Rimane poi il problema dell’hardware: senza calcolo condiviso l’accesso resta teorico. Ecco perché come si diceva si discute di consorzi pubblici di GPU, veri e propri “acquedotti computazionali” alimentati da rinnovabili, dove scuole, biblioteche e start‑up mutualistiche possano addestrare modelli senza passare dai voucher di Azure. Abbinare codice aperto, licenze protettive e infrastrutture collettive significa trasformare l’apertura da gesto simbolico a potere materiale di co‑gestione: è l’unico modo perché l’intelligenza artificiale, anziché rendita per pochi, diventi finalmente risorsa condivisa.

Negli ultimi secoli ogni tecnologia generalista ha imposto un esame di coscienza: accettare la sfida e trasformarla in terreno di conflitto, oppure rifugiarsi in un moralismo che, nel nome della purezza, finisce per congelare i rapporti di forza esistenti. Dal motore a vapore all’elettricità, dal calcolo elettronico a Internet, la storia dimostra che chi rimane fuori dal circuito dell’innovazione ne subisce semplicemente gli effetti. L’intelligenza artificiale non fa eccezione. Se la si lascia ai proprietari di data‑center, diventerà la più potente infrastruttura di estrazione di valore cognitivo mai vista; se invece la si impara a fondo, la si apre, la si alimenta con infrastrutture pubbliche e la si protegge con licenze che premino la cooperazione, può diventare leva per redistribuire tempo, reddito e ampliamento cognitivo.

Attaccare chi oggi impiega modelli proprietari come se fossero traditori di una qualche purezza etica è una posa sterilmente punitiva: la storia insegna che le tecnologie davvero utili non arretrano di fronte ai proclami morali, vengono inglobate – spesso malamente, certo, ma in modo pressoché inevitabile – nei circuiti produttivi e simbolici. È già accaduto con la corrente elettrica, con il personal computer, con i social network. E nessuno si sognerebbe crociate contro gli utenti.

Per questo la battaglia più sensata non è erigere scomuniche, ma aprire fessure nella scatola nera. È un obiettivo che sembra utopico? Certo; ma è ancor più utopico immaginare che, boicottando l’IA, questa evapori dal mondo. Meglio conoscerla, manipolarla, sovradeterminarla dall’interno, trasformando la sua presenza in terreno di conflitto e sperimentazione collettiva.

Francesco D’Isa

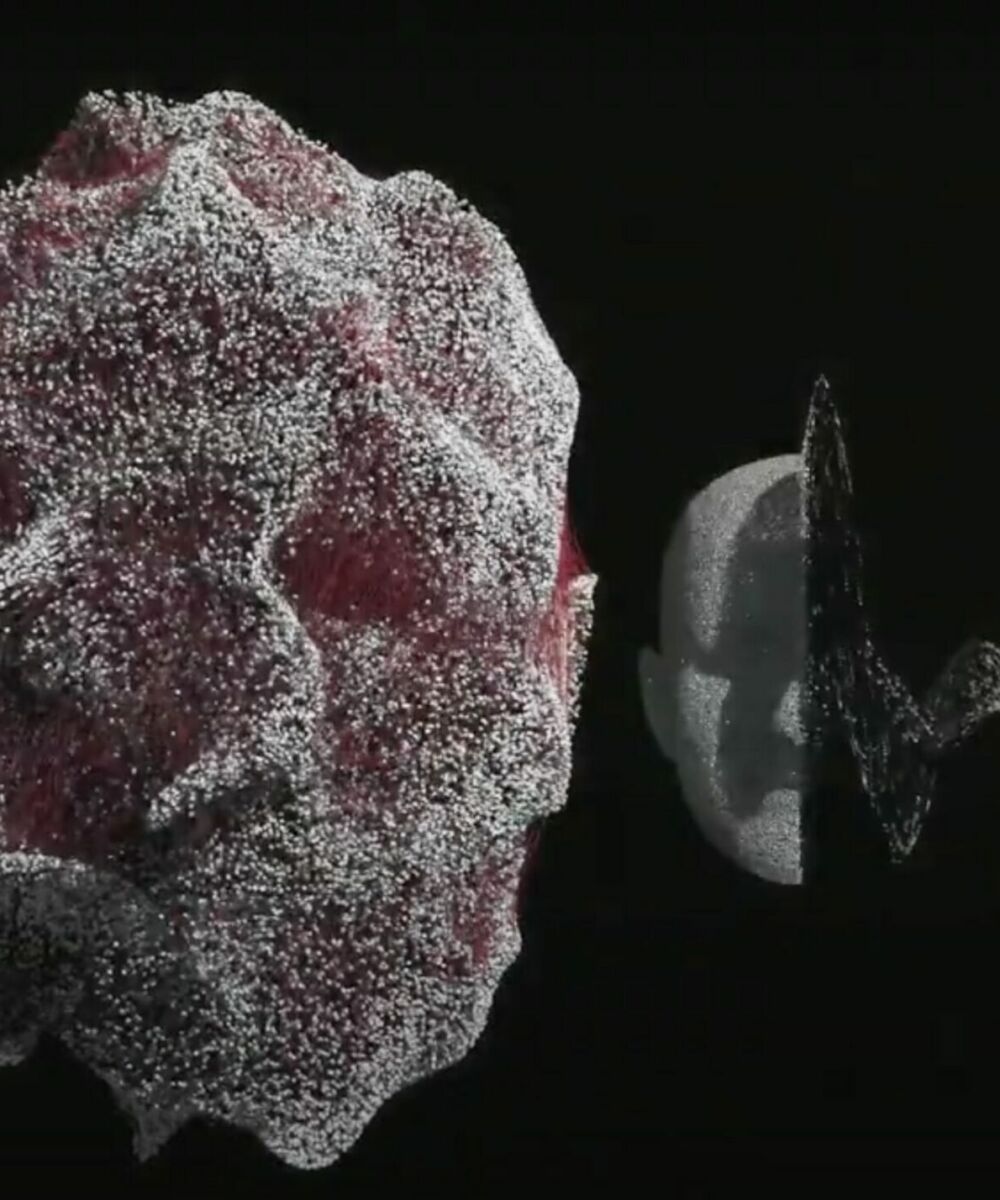

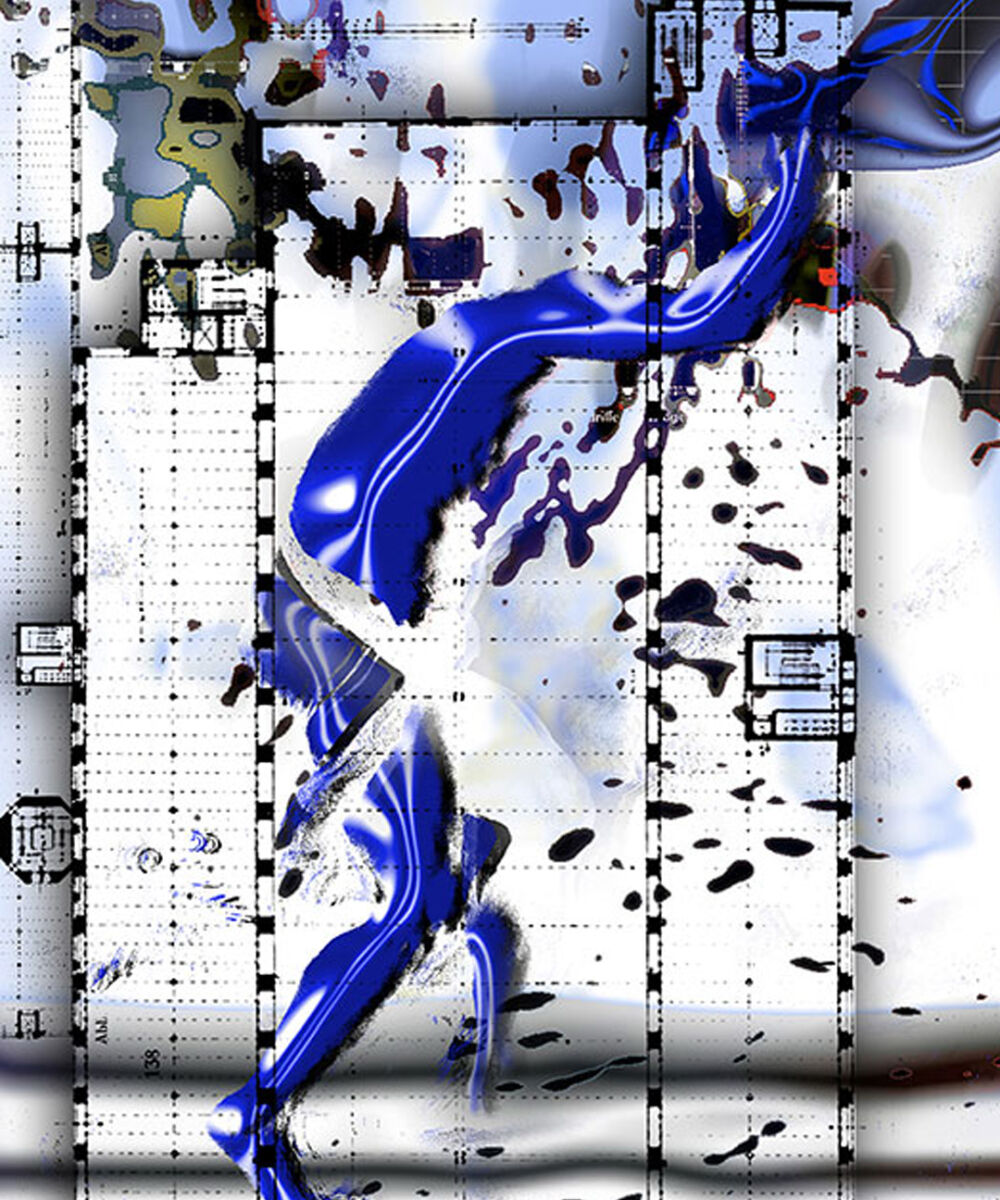

Francesco D’Isa, di formazione filosofo e artista digitale, ha esposto internazionalmente in gallerie e centri d’arte contemporanea. Dopo l’esordio con la graphic novel I. (Nottetempo, 2011), ha pubblicato saggi e romanzi per Hoepli, effequ, Tunué e Newton Compton. Il suo ultimo romanzo è La Stanza di Therese (Tunué, 2017), mentre per Edizioni Tlon è uscito il suo saggio filosofico L’assurda evidenza (2022). Le sue ultime pubblicazionio sono la graphic novel Sunyata per Eris edizioni (2023) e il saggio La rivoluzione algoritmica delle immagini per Sossella editore (2024). Direttore editoriale della rivista culturale L’Indiscreto, scrive e disegna per varie riviste, italiane ed estere. È docente di Filosofia presso l’istituto Lorenzo de’ Medici (Firenze) e di Illustrazione e Tecniche plastiche contemporanee presso LABA (Brescia).

![YESTERDAY WAS MY BIRTHDAY SO I ASKED FOR LEGS TO RUN AWAY (Yannis Mohand Briki, 2024) [3]](https://www.the-bunker.it/wp-content/uploads/2025/06/YESTERDAY-WAS-MY-BIRTHDAY-SO-I-ASKED-FOR-LEGS-TO-RUN-AWAY-Yannis-Mohand-Briki-2024-3-thegem-product-justified-square-double-page-l.jpg)